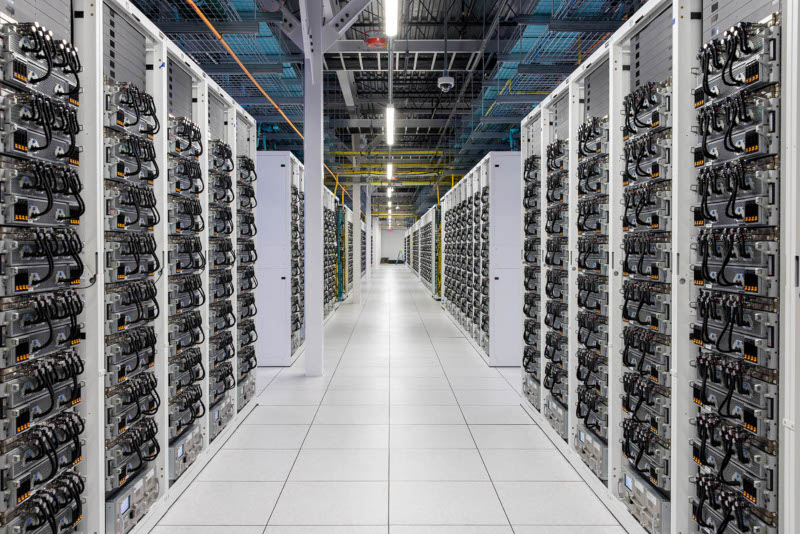

Новый дорогой проект Илона Маска (Elon Musk) — суперкомпьютер xAI Colossus для систем искусственного интеллекта, — впервые приоткрыл двери для общественности. На объект были допущены журналисты ресурса ServeTheHome. Они в подробностях рассказали о кластере на серверах Supermicro, сборка которого заняла 122 дня, — он работает уже без малого два месяца.

Источник изображения: servethehome.com

Серверы с графическими процессорами построены на платформе Nvidia HGX H100. Каждый из них включает восемь ускорителей Nvidia H100 и универсальную систему жидкостного охлаждения Supermicro 4U с поддержкой горячей замены компонентов для каждого графического процессора в отдельности. Серверы установлены в стойках по восемь штук — получаются 64 ускорителя на стойку. В нижней части каждой стойки находится ещё один блок Supermicro 4U с резервной насосной системой и системой мониторинга стойки.

Стойки сгруппированы по восемь штук, что даёт 512 графических процессоров на массив. Каждый сервер имеет четыре дублирующих блока питания; в задней части стоек можно разглядеть трёхфазные блоки питания, коммутаторы Ethernet; есть также коллекторы размером со стойки, которые обеспечивают работу жидкостного охлаждения. Кластер Colossus содержит более 1500 стоек или около 200 массивов. Ускорители на эти массивы были установлены всего за три недели, рассказал ранее глава Nvidia Дженсен Хуанг (Jensen Huang).

Из-за высоких требований к пропускной способности суперкластера ИИ, который непрерывно производит обучение моделей, инженерам xAI пришлось приложить усилия в плане сетевого взаимодействия. Каждая графическая карта оборудована выделенным сетевым контроллером на 400 GbE с дополнительным 400-Гбит сетевым адаптером на сервер. То есть у каждого сервера Nvidia HGX H100 есть Ethernet со скоростью 3,6 Тбит/с — да, весь кластер работает на Ethernet, а не на InfiniBand или других экзотических интерфейсах, стандартных для суперкомпьютеров.

Суперкомпьютеру для обучения моделей ИИ, включая Grok 3, требуются не только графические процессоры, но и накопители, а также центральные процессоры, однако информацию о них компания xAI разглашает лишь частично. На видео, подвергнутых цензуре, видно, что за это отвечают серверы на чипах x86 в корпусах Supermicro — они также оборудованы жидкостным охлаждением и предназначены либо для работы в качестве хранилищ данных, либо для рабочих нагрузок, ориентированных на центральные процессоры.

На объекте установлены также аккумуляторы Tesla Megapack. При работе кластера возможны резкие перепады в потребляемой энергии, поэтому эти батареи ёмкостью до 3,9 МВт·ч каждая пришлось установить между электросетью и суперкомпьютером в качестве энергетического буфера.

Источник: 3Dnews.ru